Sistemas Operacionais - Fundamentos, Evolução e Arquitetura

Desvendando o Invisível: Uma Introdução aos Sistemas Operacionais

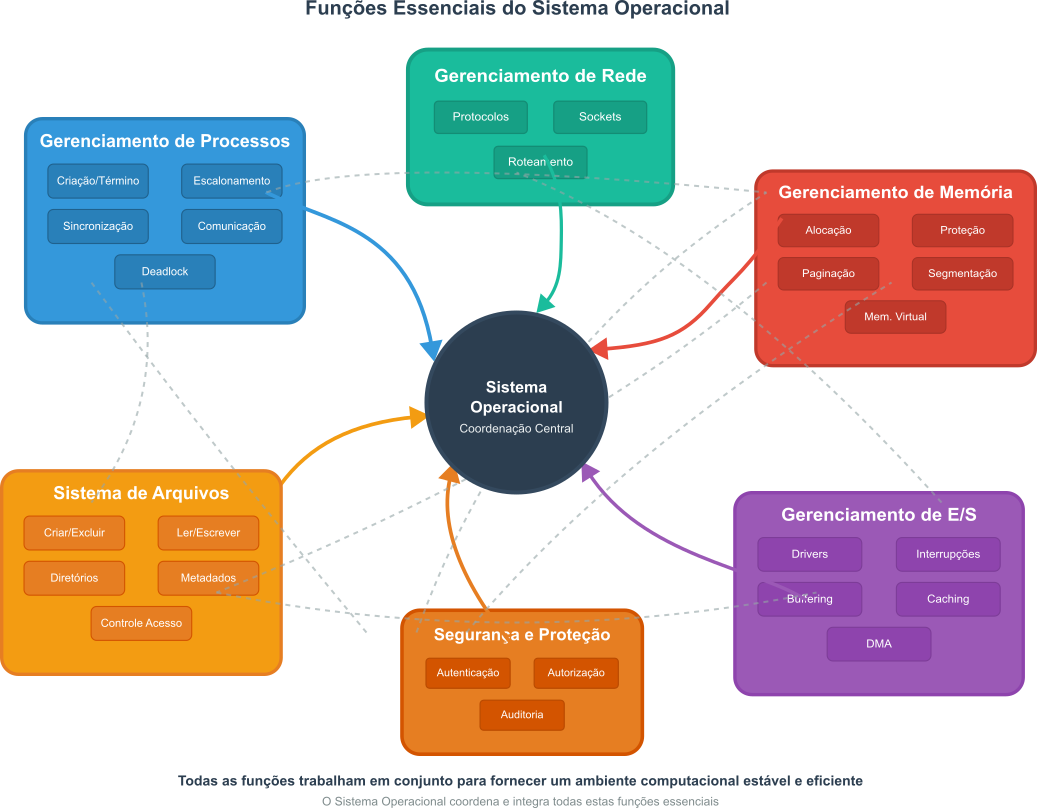

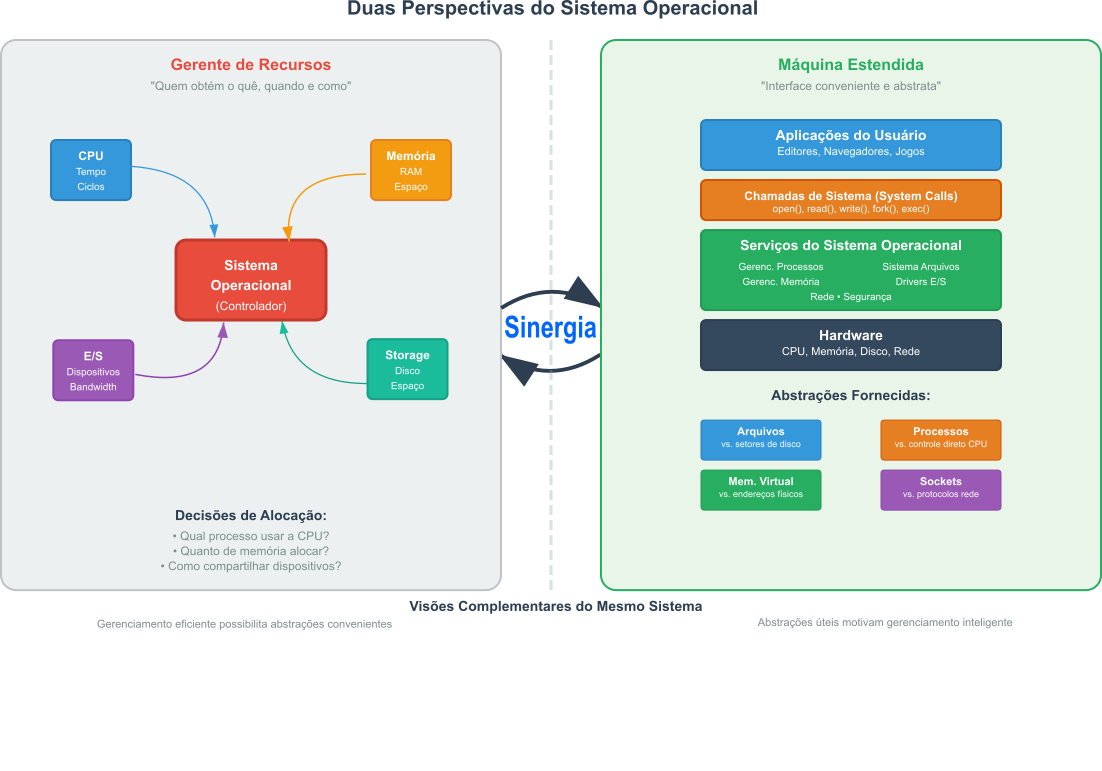

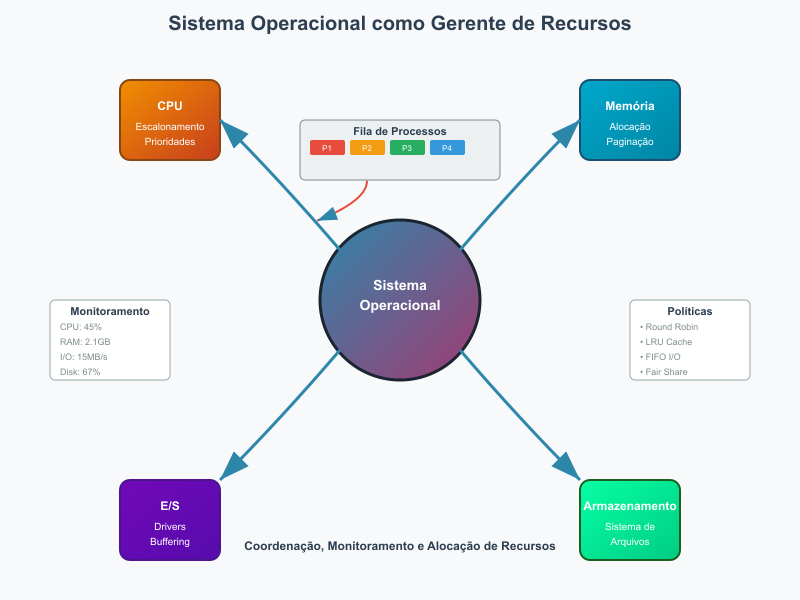

Em cada computador, smartphone ou dispositivo inteligente que utilizamos diariamente, existe um software fundamental que orquestra silenciosamente todas as operações: o sistema operacional, que como um maestro dirige uma orquestra sinfônica, coordenando cada instrumento para criar uma harmonia perfeita, coordena os sistemas de hardware e software criando um ambiente computacional funcional e eficiente. Contudo, ao contrário do maestro, cuja presença é evidente, a natureza ubíqua dos sistemas operacionais torna-os quase invisíveis para a maioria dos usuários. Quando a cuidadosa leitora salva um arquivo, executa um programa ou conecta à internet, o faz sem se dar conta dos mecanismos complexos que tornam essas ações possíveis. Ainda assim, por trás dessa aparente simplicidade, reside uma das criações mais sofisticadas e interessantes da engenharia de software: um sistema capaz de gerenciar recursos limitados, coordenar atividades concorrentes, garantir segurança e fornecer uma interface amigável, simultânea e eficientemente.

Compreender os sistemas operacionais não é apenas uma questão de curiosidade acadêmica, mas uma necessidade fundamental para qualquer profissional que deseje trabalhar com tecnologia de forma competente. Maximize esta necessidade em tempos de crescente complexidade tecnológica, nos quais as novas ferramentas e tecnologias de inteligência artificial, computação em nuvem e dispositivos móveis estão integradas em nossas vidas diárias.

Os sistemas operacionais formam as pontes entre o hardware bruto e as aplicações que utilizamos, definindo como os recursos computacionais são utilizados e como as tarefas destes sistemas são executadas. Neste ponto, a atenta leitora deve ter percebido que este conhecimento é essencial para o desenvolvimento de softwares eficientes, a resolução de problemas de desempenho e a compreensão das limitações e possibilidades dos sistemas computacionais. Se a tecnologia avança, também avançam os sistemas operacionais.

Neste texto, iremos percorrer uma jornada por meio da evolução histórica dos sistemas operacionais, desde as primeiras máquinas programáveis até os sistemas modernos que gerenciam data centers inteiros. Exploraremos as funções fundamentais que todos os sistemas operacionais devem realizar, as diferentes perspectivas por meio das quais podemos compreendê-los, e os princípios arquiteturais que orientam seu design. Nossa meta é construir uma compreensão sólida que sirva como fundação para estudos mais avançados em ciência da computação e engenharia de software.

Escrevo com a esperança, e ambição, que este seja apenas o primeiro porto que visitaremos e que, ao final desta jornada, você não apenas compreenda os sistemas operacionais, mas que seja capaz de utilizar esse conhecimento para resolver problemas práticos, otimizar sistemas e contribuir para o avanço da tecnologia. Que o céu esteja azul e que os ventos sejam justos!

A Jornada por meio do Tempo: Evolução Histórica dos Sistemas Operacionais

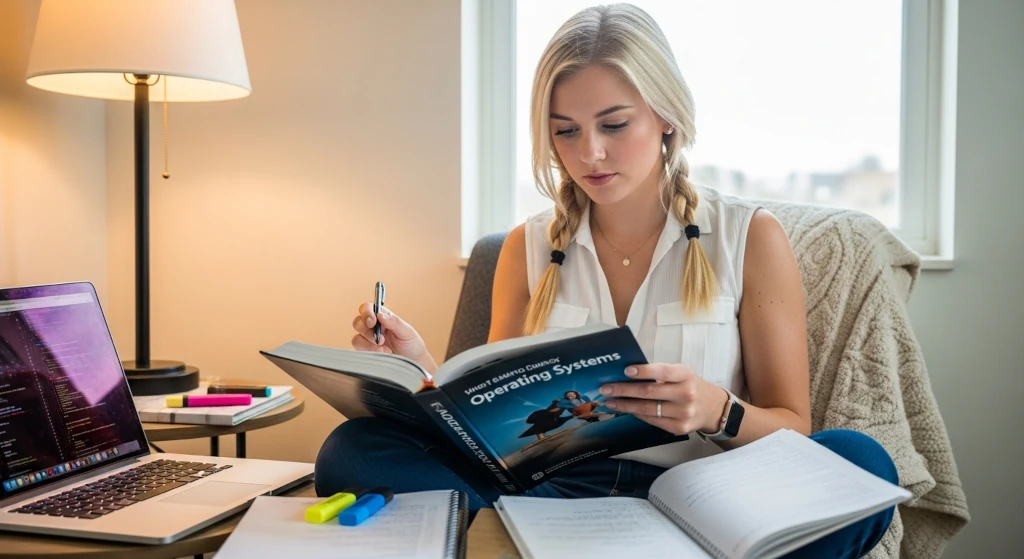

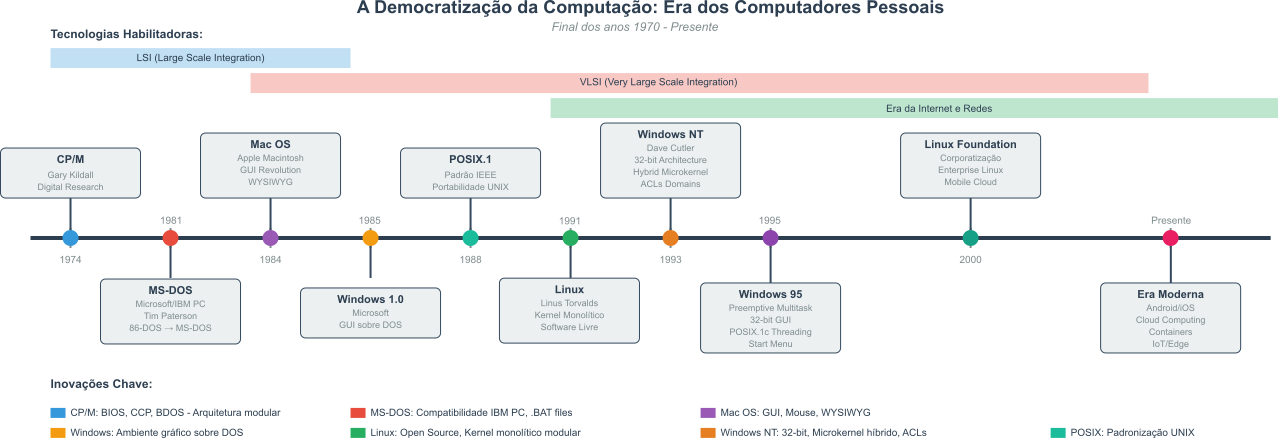

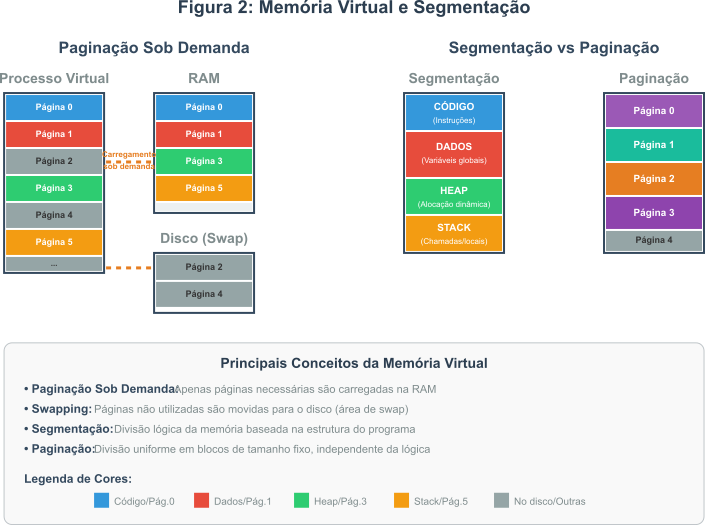

A história dos sistemas operacionais foi impulsionada pela constante evolução do hardware, pelas crescentes demandas dos usuários e, principalmente pela criatividade aplicada a solução de novos problemas ou a busca de novos recursos. A linha do tempo apresentada na Figura 1 divide e ilustra as principais eras da evolução dos sistemas operacionais de forma simples e intuitiva.

Figura 1: Linha de tempo da evolução dos sistemas operacionais

Figura 1: Linha de tempo da evolução dos sistemas operacionais

A evolução dos sistemas operacionais pode ser dividida em várias eras, cada uma marcada por inovações tecnológicas e mudanças nas necessidades dos usuários. A seguir, apresentamos um resumo das principais eras e marcos na evolução dos sistemas operacionais:

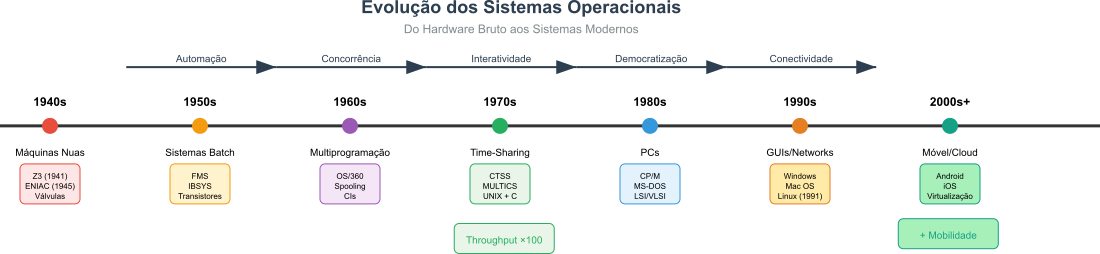

Figura 2: Evolução do Hardware → Impacto nos Sistemas Operacionais

Figura 2: Evolução do Hardware → Impacto nos Sistemas Operacionais

O tempo, e os momentos que o marcam, resumem os conceitos e avanços fundamentais mas não são suficientes. Talvez seja necessário um pouco mais de contexto para compreender como chegamos até aqui e antever até aonde podemos ir.

O Estágio Nascente: Máquinas Nuas e Programação Direta (1940s - início dos 1950s)

Os primórdios da computação, a era do bit lascado, foram caracterizados por máquinas colossais que utilizavam válvulas termiônicas e painéis de conexão (plugboards), operando sem qualquer forma de sistema operacional. Estas máquinas primitivas eram verdadeiras “máquinas nuas” (bare machines), nas quais os programadores interagiam diretamente com o hardware. Cada instrução era codificada manualmente em formato binário. Além disso, as funções que a máquina deveria executar eram controladas por meio da fiação física dos painéis de conexão. As máquina precisavam ser montadas, fisicamente configuradas, para cada tarefa específica. Muitos programadores eram especialistas em eletrônica, capazes de entender e manipular o hardware diretamente.

Como a atenta leitora deve estar imaginando, esse modo de operação era ineficiente, cansativo e tedioso. Os programadores precisavam se inscrever em listas para obter tempo de máquina, e a configuração era um processo demorado e propenso a erros. A introdução dos cartões perfurados representou uma melhoria na entrada de dados, mas a operação continuava predominantemente manual. Um computador desse período, que poderia levar dias ou até semanas para ser configurado e programado para uma tarefa específica, pode ser visto na Figura 2.

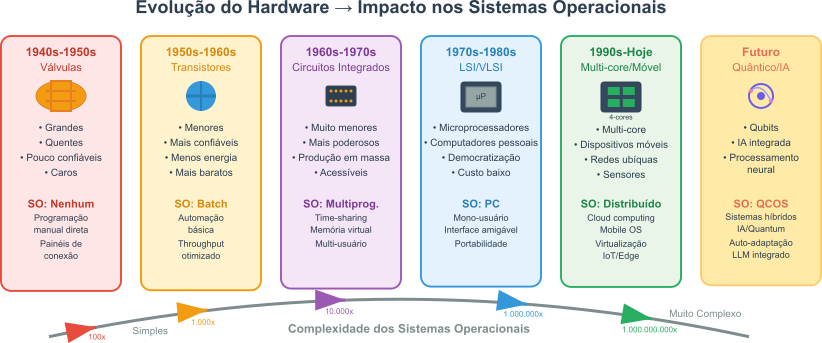

Figura 3: O ENIAC, um dos primeiros computadores programáveis, com painéis de conexão e cartões perfurados. Artificialmente colorizada.( WIKIMEDIA COMMONS, 2025)

Figura 3: O ENIAC, um dos primeiros computadores programáveis, com painéis de conexão e cartões perfurados. Artificialmente colorizada.( WIKIMEDIA COMMONS, 2025)

ENIAC

O ENIAC (Electronic Numerical Integrator and Computer) é considerado um dos primeiro computador digital eletrônico de grande escala. Este equipamento foi desenvolvido durante a Segunda Guerra Mundial e concluído em 1945. Projetado por John Presper Eckert e John William Mauchly na Universidade da Pensilvânia, o ENIAC foi criado para calcular trajetórias balísticas para o Exército dos Estados Unidos. No entanto, sua utilidade transcendeu esse propósito inicial, marcando o início da era dos computadores eletrônicos. O ENIAC era uma máquina colossal, ocupando uma área de aproximadamente 167 metros quadrados e pesando cerca de 30 toneladas. Apesar de seu tamanho e complexidade, o ENIAC era capaz de realizar cálculos em uma velocidade sem precedentes para a época, revolucionando a forma como problemas complexos podiam ser resolvidos.

Tecnologia Inovadora para a Época

O ENIAC utilizava uma tecnologia revolucionária para a época, baseada em válvulas termiônicas (ou tubos de vácuo) em vez de componentes mecânicos. Com aproximadamente 17.468 válvulas, 7.200 diodos de cristal, 1.500 relés, 70.000 resistores e 10.000 capacitores, o ENIAC era uma maravilha da engenharia eletrônica. Esses componentes permitiam que o ENIAC realizasse cálculos a uma velocidade muito maior do que qualquer máquina anterior. A programação do ENIAC era feita por meio de painéis de conexão (no inglês: plugboards) e chaves manuais, um processo complexo e demorado que exigia conhecimento especializado. Apesar de suas limitações, como a falta de um sistema operacional moderno e a necessidade de reprogramação manual para cada nova tarefa, o ENIAC estabeleceu as bases para o desenvolvimento de computadores mais avançados e acessíveis, pavimentando o caminho para a revolução digital que viria a seguir.

O ENIAC, é um marco importante na história da computação. Mas, não foi o primeiro computador, nem o único. Outros computadores notáveis dessa era incluem o Colossus, usado para decifrar códigos durante a Segunda Guerra Mundial, e o EDVAC, que introduziu o conceito de armazenar programas na memória. E, graças aos problemas da segunda guerra mundial, ficou esquecido. Relegado a poeira do preconceito e medo.

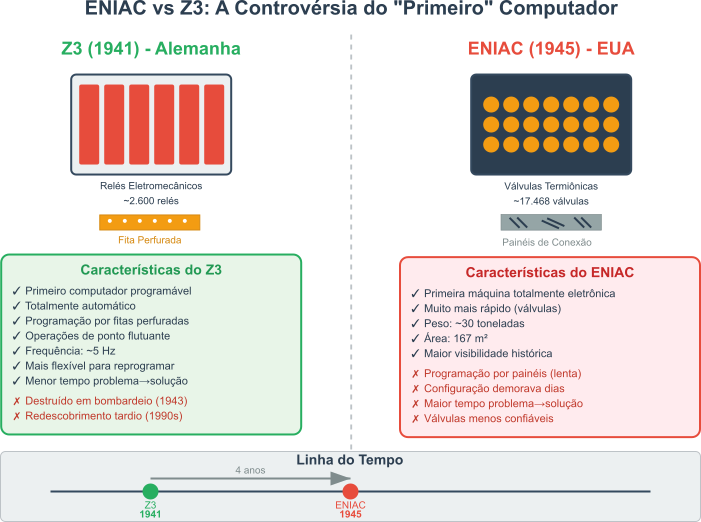

O processo de redescoberta e reconhecimento da relevância do Z3 começou a ganhar força na década de 1990. Um marco importante ocorreu após a morte de Konrad Zuse, em 1995, quando houve um renovado interesse em seu trabalho, reacendendo debates sobre qual foi o primeiro computador da história. Além disso, em 1998, foi demonstrado que o Z3 era, em princípio, Turing-completo, ou seja, capaz de realizar qualquer cálculo que um computador moderno poderia fazer, desde que devidamente programado. Essa demonstração solidificou a posição do Z3 como um avanço fundamental na evolução da computação.

O Zuse Z3

O Zuse Z3, criado pelo engenheiro alemão Konrad Zuse em 1941, é reconhecido como o primeiro computador programável e totalmente automático do mundo. Desenvolvido em Berlim, o Z3 foi uma inovação significativa na computação, utilizando relés eletromecânicos para realizar cálculos complexos. Zuse construiu o Z3 para resolver problemas de engenharia, e a máquina foi usada para cálculos estruturais e aerodinâmicos. Embora o Z3 tenha sido destruído durante um bombardeio aliado em 1943, sua arquitetura e conceitos pioneiros influenciaram profundamente o desenvolvimento subsequente dos computadores. O Z3 era capaz de realizar operações de ponto flutuante mas possuía uma memória limitada. Ainda assim, suficiente para as tarefas da época. A máquina era programada por meio de fitas perfuradas, o que permitia uma certa flexibilidade na execução de diferentes tarefas.

Tecnologia e Legado do Zuse Z3

O Z3 utilizava cerca de 2.600 relés eletromecânicos para realizar suas operações lógicas e aritméticas, uma tecnologia avançada para a época, mas limitada em comparação com os computadores eletrônicos que surgiriam posteriormente. A máquina operava com uma frequência de clock de aproximadamente 5 Hz, o que, embora lento pelos padrões atuais, era uma conquista notável para a tecnologia da época. O Z3 também introduziu conceitos fundamentais de computação, como a separação entre programa e dados, e a capacidade de executar operações condicionais. Apesar de suas limitações, o Z3 demonstrou a viabilidade de computadores programáveis e automáticos, abrindo caminho para desenvolvimentos futuros. O trabalho de Konrad Zuse é considerado pioneiro e visionário, e seu legado continua a ser celebrado na história da computação.

Observe, atenta leitora, que o Eniac usava válvulas termiônicas, enquanto o Z3 utilizava relés eletromecânicos. Isto parece implicar que o ENIAC era muito mais rápido. Contudo, o Z3 era programado por fitas perfuradas, enquanto o ENIAC utilizava painéis de conexão. O que significa que o Z3 era mais flexível e fácil de programar. Ou seja, este pobre autor acredita que o tempo entre a definição do problema e a solução do mesmo era menor no Z3 do que no ENIAC. O que, em última análise, é o que importa.

Figura 4: Comparação entre o ENIAC e o Z3, destacando as diferenças em tecnologia, programação e velocidade.

Figura 4: Comparação entre o ENIAC e o Z3, destacando as diferenças em tecnologia, programação e velocidade.

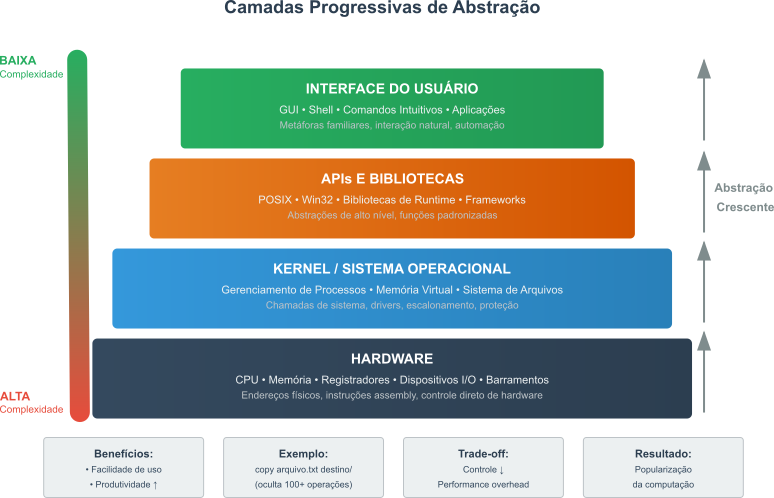

Para vértices, nesta jornada, o mais importante é compreender que, mesmo sem sistemas operacionais, os computadores já eram capazes de realizar tarefas complexas. No entanto, a falta de abstração e automação tornava o processo trabalhoso, dolorosamente tedioso e propenso a erros. Nesse ponto da história começa a surgir a necessidade de camada extra de tecnologia que permitisse automatizar as tarefas necessárias para resolver problemas computacionais, sem a necessidade de intervenção manual constante.

A Revolução Batch: Automatizando o Throughput (final dos 1950s - meados dos 1960s)

Throughput é uma palavra horrível A palavra “throughput” da língua inglesa, não tem uma tradução direta para o português. Pode ser entendida como vazão, taxa de transferência ou capacidade de processamento. No contexto de sistemas operacionais, refere-se à quantidade de trabalho que um sistema pode realizar em um determinado período de tempo. É uma métrica importante para avaliar a eficiência e o desempenho de um sistema, especialmente em ambientes de computação nos quais múltiplas tarefas são executadas simultaneamente.

Eu vou usar throughput, na esperança que Cecília Meireles e Fernando Pessoa me perdoem o estrangeirismo.

Conceito Fundamental: Throughput vs Latência

Throughput é frequentemente confundido com velocidade, mas representa algo mais sutil:

Analogia da Fábrica:

- Throughput: Quantos carros a fábrica produz por dia

- Latência: Quanto tempo leva para um carro específico ser completado

No Contexto dos Sistemas Batch:

Antes (Operação Manual): Job 1: ████████ (8h total, 2h CPU) Job 2: ████████ (8h total, 2h CPU) Throughput: 2 jobs/16h = 0.125 jobs/hora Depois (Sistema Batch): Job 1: ██ (2h CPU) Job 2: ██ (2h CPU) Job 3: ██ (2h CPU) Throughput: 3 jobs/6h = 0.5 jobs/horaResultado: 4x mais throughput com o mesmo hardware!

A substituição das válvulas por transistores tornou os computadores menores, mais confiáveis, rápidos e práticos. Contudo, e apesar disso, as máquinas da época eram extremamente caras e gerenciados centralmente. Estas grandes máquinas centralizadas ficaram conhecidas como mainframes. Elas eram operadas por equipes de especialistas e utilizadas principalmente para tarefas críticas em grandes organizações, como bancos e universidades. E enfrentavam um problema significativo: a subutilização da unidade central de processamento. A unidade central de processamento, que ficou conhecida como CPU, ficava ociosa enquanto esperava por operações de Entrada/Saída (E/S) ou pela conclusão de outros processos, resultando em desperdício de recursos.

A solução emergiu na forma de Sistemas Batch.

Os sistemas batch, uma palavra do inglês que pode ser traduzida por lote, apresentavam características distintas que os diferenciavam das abordagens anteriores de computação. Uma das principais inovações era a capacidade de agrupar tarefas com necessidades similares, formando lotes, ou batchs, que eram executados de maneira sequencial, permitindo uma utilização mais eficiente dos recursos computacionais. Esses sistemas contavam com um monitor residente, um componente precursor dos sistemas operacionais modernos, que tinha a função de automatizar o sequenciamento dos trabalhos, eliminando a necessidade de intervenção manual entre a execução de cada tarefa. Para controlar esse processo, foi desenvolvida a Job Control Language (JCL), uma linguagem específica que permitia instruir o monitor sobre como processar os trabalhos (do inglês, jobs), definindo parâmetros e sequências de execução. Além disso, os sistemas batch introduziram o conceito de processamento offline, no qual a saída dos trabalhos era direcionada para fitas magnéticas, permitindo que a impressão dos resultados fosse realizada posteriormente, sem ocupar o valioso tempo de processamento da unidade central de processamento. Essa abordagem representou um avanço significativo na automação da operação dos computadores, aumentando consideravelmente a utilização da CPU e o throughput dos sistemas.

Sistemas influentes desta era:

-

FMS (Fortran Monitor System): um dos primeiros sistemas de monitoramento para programas FORTRAN. O FMS foi um dos primeiros sistemas de monitoramento desenvolvido especificamente para programas escritos em FORTRAN (do inglês: FORmula TRANslation), uma das primeiras linguagens de programação, utilizada para aplicações científicas e de engenharia de alto desempenho ainda hoje. O FMS permitia que múltiplos programas FORTRAN fossem executados em sequência sem a necessidade de intervenção manual entre cada execução. O FMS introduziu os conceitos básicos de gerenciamento de tarefas e alocação de recursos, que se tornariam fundamentais para os sistemas operacionais. Além disso, o FMS facilitava a compilação e execução de programas FORTRAN, tornando o processo de desenvolvimento mais eficiente e menos propenso a erros.

-

IBSYS: sistema batch para o IBM 7094, que estabeleceu alguns conceitos importantes até hoje. O IBSYS introduziu técnicas sofisticadas de gerenciamento de memória e escalonamento de tarefas, permitindo que múltiplos trabalhos fossem processados de maneira mais eficiente. O IBSYS também implementou mecanismos de proteção de memória, garantindo que um programa não interferisse na execução de outros, um conceito importante para a estabilidade e confiabilidade dos sistemas computacionais. Além disso, o IBSYS oferecia suporte a dispositivos de entrada e saída diversos, incluindo leitores de cartões, impressoras e unidades de fita magnética, permitindo uma maior flexibilidade na manipulação de dados.

O objetivo principal dos sistemas Batch era maximizar a utilização da CPU e o throughput. Deve voltar a definição de throughput, só por via das dúvidas. A atenta leitora deve registrar que esta era marcou o primeiro passo na automação da operação do computador e impulsionou o conceito de abstração da máquina.

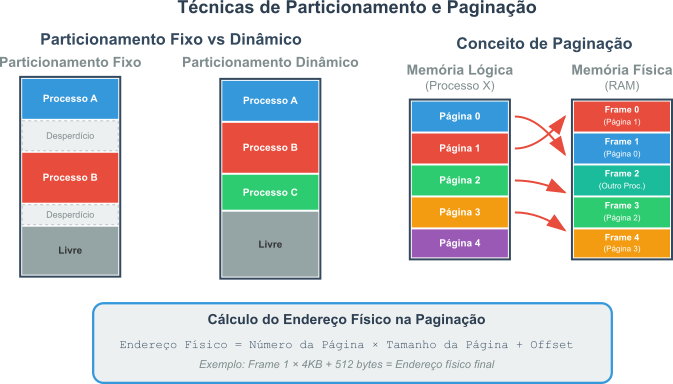

Malabarismo de Recursos: O Advento da Multiprocessamento (meados dos 1960s - 1970s)

A introdução dos Circuitos Integrados (CIs) marcou um avanço significativo, resultando em computadores ainda mais poderosos, compactos e acessíveis. No entanto, mesmo com a eficiência aprimorada dos sistemas batch, um problema persistia: a CPU permanecia ociosa durante as operações de entrada e saída de dados (E/S). O gargalo residia no fato de que as operações de E/S são ordens de magnitude mais lentas do que a execução de instruções pela CPU.

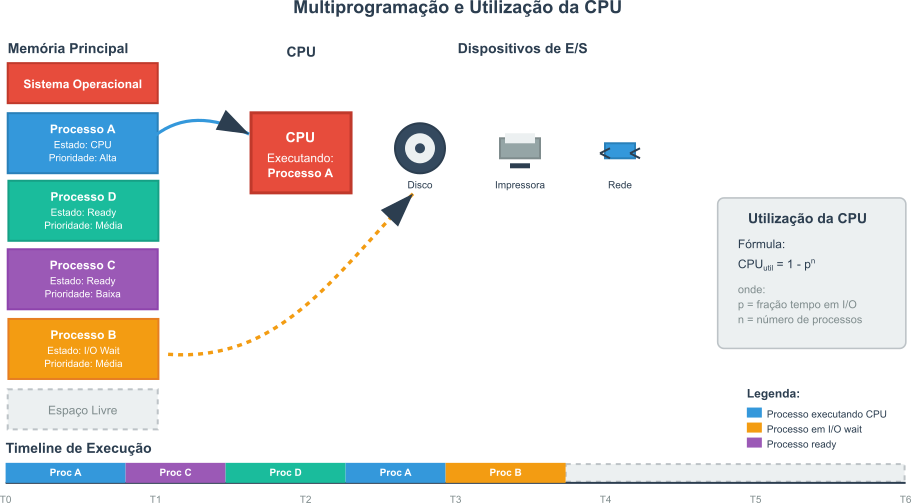

Nesse contexto surgiu a Multiprocessamento. Essa técnica revolucionária propunha manter múltiplos processos na memória principal simultaneamente. A ideia era simples, mas transformadora: se um processo em execução precisasse realizar uma operação de E/S, um sistema de gestão poderia rapidamente comutar a CPU para outro processo que estivesse pronto para executar, em vez de esperar o término da lenta operação de E/S. Essa abordagem aumentou drasticamente a utilização da CPU, reduziu o tempo ocioso e revolucionou a forma como os recursos computacionais são gerenciados.

A eficácia da Multiprocessamento pode ser modelada matematicamente. Se um processo gasta uma fração $p$ do seu tempo esperando por operações de E/S, a probabilidade de $n$ processos, todos residentes na memória, estarem simultaneamente esperando por E/S é $ p^n $. A CPU só estará ociosa se todos os processos estiverem esperando. Portanto, a utilização da CPU é a probabilidade de que pelo menos um processo não esteja esperando por E/S, o que pode ser expresso pela fórmula:

\[\text{Utilização da CPU} = 1 - p^n\]Nesta equação:

- $p$ representa a fração de tempo que um processo gasta em operações de E/S.

- $n$ é o número total de processos mantidos na memória.

Demonstração Prática: O Poder da Multiprocessamento

A fórmula $\text{Utilização da CPU} = 1 - p^n$ pode parecer abstrata, mas seus resultados são impressionantes:

Cenário: Processos gastam 50% do tempo em I/O ($p = 0.5$)

Processos (n) $p^n$ Utilização da CPU Melhoria 1 0.5 50% - 2 0.25 75% +50% 4 0.0625 93.75% +87.5% 8 0.0039 99.61% +99.2% Observação Importante: com apenas 4 processos na memória, obtemos quase 94% de utilização da CPU, mesmo quando cada processo passa metade do tempo esperando I/O!

Limitação Prática: Esta análise assume que sempre há pelo menos um processo pronto para executar e não considera o custo computacional da troca de contexto.

Como a esperta leitora deve observar que, mesmo com um valor de $p$ relativamente alto (por exemplo, 0.5, significando que os processos passam metade do tempo em E/S), aumentar o número de processos $n$ na memória faz com que o termo $p^n$ diminua exponencialmente, levando a utilização da CPU para perto de 100%.

Figura 5: Representação da alocação de processos em memória.

Figura 5: Representação da alocação de processos em memória.

Em resumo, a Multiprocessamento introduziu conceitos fundamentais que moldaram a construção dos sistemas operacionais. Entre eles, destacam-se:

- Múltiplos jobs na memória: permitia que vários trabalhos fossem mantidos simultaneamente na memória principal;

- Comutação de contexto: quando um job necessitava realizar operações de E/S, o sistema de gestão rapidamente transferia a CPU para outro job pronto para execução;

- Gerenciamento de memória: surgia a necessidade de alocar espaço para múltiplos trabalhos de forma eficiente;

- Escalonamento de CPU: eram desenvolvidos algoritmos para decidir qual job seria executado em seguida, otimizando o uso da CPU.

jobs: o termo “job” refere-se a uma tarefa ou trabalho que um sistema operacional deve executar. Em sistemas batch, um job é um conjunto de instruções e dados que são processados em sequência, sem interação do usuário durante a execução. Os jobs são frequentemente agrupados com base em suas características ou requisitos de recursos, permitindo que o sistema operacional otimize o uso da CPU e minimize o tempo de espera. O equivalente atual do job é o processo, que é uma instância de um programa em execução, incluindo seu estado, dados e recursos alocados.

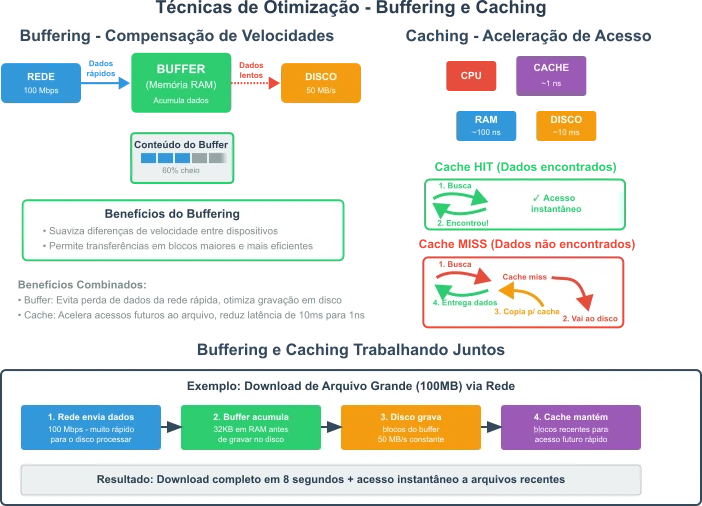

Outro avanço significativo foi o Spooling (Simultaneous Peripheral Operation On-Line), uma técnica que utilizava o disco como buffer intermediário para operações de E/S. Isso permitia que a CPU e os dispositivos de E/S operassem de forma mais concorrente, melhorando a eficiência geral do sistema. Um exemplo marcante dessa era é o OS/360 da IBM, em 7 de abril de 1964, um sistema de Multiprocessamento que estabeleceu muitos dos conceitos ainda utilizados nos sistemas operacionais modernos. O termo OS/360 refere-se a uma família de sistemas operacionais desenvolvidos pela IBM para sua linha de mainframes System/360, que introduziu a Multiprocessamento como um recurso central. O OS/360 foi projetado para suportar uma ampla gama de aplicações, desde processamento de dados até computação científica, e estabeleceu padrões que influenciaram profundamente o desenvolvimento de sistemas operacionais subsequentes.

Spooling vem do inglês Simultaneous Peripheral Operations On-Line e refere-se ao processo de gerenciamento de dados para operações de entrada e saída (E/S). Ele permite que dispositivos periféricos, como impressoras, operem de forma eficiente, armazenando temporariamente os dados em uma área de buffer, uma área de memória temporária ou fila, sem interromper o processamento principal da CPU.

buffer é um destes termos em inglês que chegaram na computação, em inglês, de uma forma pouco ortodoxa. Talvez, algum pesquisador tenha se lembrado de algo da infância, ou de alguma outra área do vida e trouxe para a computação. O termo “buffer” deriva do verbo em inglês antigo “buff”, que significava golpear ou amortecer um golpe. Esse sentido inicial estava ligado à ideia de suavizar ou absorver um impacto físico, como uma pancada. Na física, um “buffer” é um dispositivo ou mecanismo que reduz o impacto ou choque, como os amortecedores usados em trens ou carros para suavizar colisões. Também pode se referir a algo ou alguém que funciona como uma barreira protetora. Em computação Um “buffer” é uma área de armazenamento temporário para dados, usada enquanto eles estão sendo transferidos entre dois lugares, ou processos, distintos. Por exemplo, um buffer pode guardar informações de um dispositivo rápido, como um processador, antes de enviá-las para um dispositivo mais lento, como uma impressora, ajudando a equilibrar diferenças de velocidade1.

Novamente: o poetas mortos da língua portuguesa perdoai este pobre autor pelos crimes que comete!

A IBM não criou o termo sistema operacional, mas foi fundamental em sua popularização. O termo já existia na comunidade de computação antes do lançamento do OS/360 pela IBM em 1964. Por exemplo, sistemas como o GM-NAA I/O, desenvolvido em 1956, e o CTSS, descrito em 1962, já eram chamados de sistemas operacionais em contextos acadêmicos e de pesquisa. No entanto, o OS/360, marcou um ponto de virada na história da computação. Deste ponto em diante, podemos usar o termo sistema operacional para nos referirmos a um software que gerencia recursos de hardware e fornece serviços essenciais para programas de aplicação. A Multiprocessamento e o spooling foram marcos importantes na evolução dos sistemas operacionais, estabelecendo as bases para a abstração de hardware e a automação do gerenciamento de recursos.

Era da Interatividade: Sistemas de Tempo Compartilhado (final dos 1960s - 1980s)

Os sistemas de tempo compartilhado, do inglês time-sharing, representaram uma evolução natural da Multiprocessamento, com um foco especial na experiência do usuário além eficiência no uso da CPU. Esses sistemas revolucionaram a computação ao dividir o tempo da CPU entre múltiplos usuários interativos simultaneamente, criando um ambiente no qual cada usuário tinha a impressão de estar utilizando um computador dedicado exclusivamente a ele.

A abordagem de time-sharing marcou uma mudança significativa de paradigma nos sistemas computacionais. Essa transição foi possível graças à implementação do time slicing. Nome em inglês para uma técnica na qual cada processo recebe uma pequena fatia de tempo da CPU, que podemos chamar de quantum para aproveitar os tempos atuais e o conceito da física, antes de ser temporariamente suspenso para permitir que outros processos sejam executados. Essa abordagem cria a ilusão de que cada usuário tem acesso exclusivo aos recursos do computador, melhorando significativamente a interatividade e a experiência geral do usuário.

O uso dos conceitos de time slicing, inglês para fatiamento de tempo, permitiram que múltiplos usuários trabalhassem simultaneamente no mesmo sistema, cada um com a impressão de estar utilizando um computador dedicado, enquanto na realidade os recursos eram compartilhados de maneira eficiente e transparente.

Sistemas Influentes:

Entre os sistemas de tempo compartilhado mais influentes da história da computação, destacam-se três que deixaram um legado significativo.

-

CTSS (Compatible Time-Sharing System): desenvolvido no Massachusetts Institute of Technology (MIT). Este sistema foi pioneiro no uso de fatiamento de tempo com interrupções, uma técnica que permitia a múltiplos usuários compartilharem os recursos de um computador de maneira eficiente. O CTSS estabeleceu muitos dos conceitos fundamentais que ainda hoje são a base dos sistemas interativos modernos, incluindo mecanismos de alocação de recursos e gerenciamento de processos que garantiam uma experiência de usuário mais responsiva e interativa.

-

MULTICS (Multiplexed Information and Computing Service): resultado de um projeto colaborativo entre o MIT, a General Electric e os Bell Labs. O MULTICS introduziu uma série de conceitos revolucionários que mudaram para sempre a computação. Entre essas inovações estavam a memória de nível único, que simplificava o gerenciamento de memória, a ligação dinâmica de código, que permitia maior flexibilidade na execução de programas, e um sistema de arquivos hierárquico, que organizava os dados de maneira mais intuitiva. Além disso, o MULTICS tinha um forte foco em segurança, introduzindo mecanismos avançados de proteção de dados e controle de acesso. Embora o MULTICS tenha tido um sucesso comercial limitado, sua influência no desenvolvimento de sistemas operacionais subsequentes foi imensa, estabelecendo padrões que ainda são seguidos hoje.

-

UNIX, desenvolvido nos Bell Labs por Ken Thompson e Dennis Ritchie, merece destaque especial. Inspirado pelo MULTICS, o UNIX foi criado com uma filosofia de simplicidade e elegância que o tornou extremamente popular. Diferente de seu predecessor, o UNIX foi escrito predominantemente na Linguagem C, o que lhe conferiu uma portabilidade notável, permitindo que fosse executado em uma variedade de plataformas de hardware. O UNIX também se destacou por seu ambiente multiusuário e multitarefa, que permitia que múltiplos usuários trabalhassem simultaneamente no mesmo sistema, cada um executando várias tarefas ao mesmo tempo. Os sistemas UNIX de 1993 apresentavam pilhas TCP/IP maduras (sockets BSD desde 1983), memória virtual sofisticada com paginação por demanda (4.3BSD), sistemas de arquivos avançados e capacidades de computação distribuída por meio de NFS e RPC.Além disso, o UNIX introduziu um sistema de arquivos hierárquico e um shell de comando poderoso, que oferecia aos usuários uma interface flexível e eficiente para interagir com o sistema.

O nome “UNIX” é uma brincadeira derivada de “Multics”, um sistema operacional anterior no qual seus criadores trabalharam. O Multics era um projeto ambicioso, mas complexo e pesado. Quando Ken Thompson e Dennis Ritchie começaram a desenvolver um sistema mais simples e eficiente, chamaram-no de UNIX como um trocadilho, sugerindo algo mais unitário e simplificado em contraste com o Multics. O nome também pode ser interpretado como uma abreviação de “UNIpleXed Information and Computing Service”, embora isso seja mais uma explicação retroativa do que a intenção original.

A Linguagem C foi criada por Dennis Ritchie na Bell Labs entre 1972 e 1973, sendo desenvolvida especificamente para facilitar o desenvolvimento do sistema operacional UNIX. Dennis Ritchie descreveu o C como “uma linguagem de implementação de sistema para o nascente sistema operacional UNIX”. Cronologicamente temos:

**UNIX inicial (1969-1971): **UNIX foi originalmente escrito em assembly language para o computador PDP-7

Desenvolvimento da linguagem B: Ken Thompson primeiro criou a linguagem B, uma versão simplificada do BCPL, para desenvolver utilitários para o UNIX

Evolução para **C (1971-1973)**: Em 1971, Ritchie começou a melhorar a linguagem B para aproveitar recursos do PDP-11 mais poderoso, adicionando tipos de dados como caracteres. Esta versão foi chamada “New B” (NB) e posteriormente evoluiu para C

Reescrita do **UNIX em C (1973): Na versão 4 do **UNIX, lançada em novembro de 1973, o kernel do UNIX foi extensivamente reimplementado em C

A Linguagem C foi projetada para ser uma linguagem de programação de sistemas, com foco em eficiência, portabilidade e expressividade. Ela permitiu que o UNIX fosse reescrito de forma mais concisa e legível, facilitando a manutenção e evolução do sistema. Conforme mais do sistema operacional foi reescrito em C, a portabilidade também aumentou, permitindo que o UNIX rodasse em diferentes arquiteturas de computador. Além disso, a Linguagem C tinha o objetivo de mover o código do kernel UNIX do assembly para uma linguagem de alto nível, que realizaria as mesmas tarefas com menos linhas de código. Finalmente, Dennis Ritchie construiu a Linguagem C sobre a linguagem B, herdando a sintaxe concisa de Thompson que tinha uma poderosa mistura de funcionalidades de alto nível com os recursos detalhados necessários para programar um sistema operacional que fosse portável entre diferentes plataformas de hardware.

O desenvolvimento do UNIX ilustra um princípio importante no design de sistemas: soluções pragmáticas e focadas muitas vezes ganham maior adoção do que aquelas excessivamente ambiciosas e complexas. A portabilidade do UNIX, facilitada pela Linguagem C, foi um divisor de águas, permitindo sua disseminação por uma vasta gama de plataformas de hardware.

Kernel vs Sistema Operacional

Chamamos de kernel o componente central e mais crítico do sistema operacional. Esta será a primeira parte do sistema operacional que será carregada na memória durante o boot. O Kernel contém as funções necessárias para atuar como uma ponte direta entre hardware e software. O Kernel opera no nível mais baixo do sistema, gerenciando recursos fundamentais como processos, decidindo qual programa usa a CPU e por quanto tempo, memória RAM, controlando alocação e proteção entre programas, dispositivos de hardware, por meio de drivers, e fornecendo interfaces para que aplicações solicitem serviços do sistema. O kernel é essencialmente invisível ao usuário comum, operando em modo privilegiado para garantir estabilidade e segurança do sistema.

O sistema operacional, por sua vez, é o conjunto completo de software que inclui o kernel mais todos os componentes que tornam o computador utilizável para o usuário final. Além do kernel, um Sistema Operacional engloba interfaces de usuário, ambientee para interpretação de comandos (shell), sistema de arquivos para organização de dados, utilitários de sistema como gerenciadores de arquivos e painéis de controle, e bibliotecas de sistema que fornecem APIs para desenvolvimento de aplicações. Estes componentes trabalham em conjunto para criar uma experiência coesa e funcional.

Pessoas mais inteligentes que eu, dizem que a tecnologia, e a civilização, avançam em rampas e degraus. De tempos em tempos, uma inovação ou descoberta significativa ocorre, criando um salto qualitativo na capacidade tecnológica. O par UNIX e C é, claramente, um destes degraus.

A Democratização da Computação: Era dos Computadores Pessoais (final dos 1970s - presente)

A invenção e popularização dos microprocessadores, impulsionadas pelos avanços em LSI (Large Scale Integration) integração em larga escala em inglês e em VLSI (Very Large Scale Integration), integração em escala muito grande em inglês, levaram ao surgimento de computadores pessoais acessíveis. A curiosa leitora precisa saber que no final dos anos 1980, no Brasil, era mais fácil comprar um computador pessoal importado, que um telefone.

As novas tecnologias de microprocessadores permitiram a miniaturização e a redução de custos, tornando possível a criação de computadores que poderiam ser adquiridos por indivíduos e pequenas empresas. Esses computadores pessoais, ou PCs, eram significativamente mais baratos do que os mainframes e minicomputadores da época, tornando a computação acessível a um público muito mais amplo.

Esta era representou uma mudança drástica do modelo de computação centralizada para sistemas de usuário individual.

Figura 6: Linha do tempo da evolução dos sistemas operacionais para computadores pessoais.

Figura 6: Linha do tempo da evolução dos sistemas operacionais para computadores pessoais.

Sistemas Influentes:

- CP/M (Control Program for Microcomputers) - Desenvolvido por Gary Kildall na Digital Research em 1974, o CP/M foi um marco fundamental na evolução dos sistemas operacionais para microcomputadores. Este sistema estabeleceu convenções duradouras para a organização de arquivos e comandos que influenciariam profundamente o desenvolvimento posterior de sistemas como o MS-DOS. O CP/M introduziu o conceito de Basic Input/Output System (BIOS), uma camada de abstração entre o hardware e o sistema operacional que permitia maior portabilidade entre diferentes microcomputadores baseados no processador Intel 8080 e Zilog Z80. Sua estrutura modular, com Command Console Processor (CCP), Basic Disk Operating System (BDOS) e BIOS, tornou-se um modelo arquitetônico para sistemas posteriores. Durante o final dos anos 1970 e início dos 1980, o CP/M dominou o mercado de microcomputadores comerciais, estabelecendo padrões para nomenclatura de drives (A:, B:, C:) e comandos básicos que persistem até hoje2.

- MS-DOS (Microsoft Disk Operating System) - Originado como uma adaptação do 86-DOS (QDOS - Quick and Dirty Operating System) desenvolvido por Tim Paterson na Seattle Computer Products, o MS-DOS foi adquirido pela Microsoft em 1981 para atender à demanda da IBM por um sistema operacional para seu novo Personal Computer. O sistema mantinha compatibilidade conceitual com o CP/M, facilitando a migração de aplicações, mas foi otimizado para o processador Intel 8086/8088. Sua interface de linha de comando, embora aparentemente simples, oferecia recursos poderosos como redirecionamento de entrada/saída, processamento em lote por meio de arquivos .BAT, e suporte a dispositivos por meio de drivers carregáveis. O MS-DOS evoluiu significativamente ao longo de suas versões, introduzindo suporte a discos rígidos (versão 2.0), estruturas de diretórios hierárquicas, e eventualmente suporte limitado à memória estendida. Sua natureza monotarefa e arquitetura de 16 bits, embora limitantes, proporcionaram estabilidade e previsibilidade que contribuíram para o estabelecimento do padrão IBM PC como plataforma dominante na computação pessoal por mais de uma década3.

-

Apple Macintosh OS (Classic Mac OS) - Lançado em 1984, o Sistema Operacional do Macintosh representou uma revolução paradigmática na interação humano-computador, popularizando conceitos que hoje consideramos fundamentais na computação moderna. Inspirado no trabalho pioneiro realizado nos Laboratórios Xerox Alto e Star, o Mac OS implementou de forma comercialmente viável a metáfora da área de trabalho. Nesta metáfora arquivos eram representados como documentos físicos e pastas como contêineres organizacionais. O sistema aproveitou as ideias dos Laboratórios da Xerox e introduziu o mouse como dispositivo primário de navegação, implementou o conceito de WYSIWYG, abreviatura do What You See Is What You Get, na edição de documentos, e estabeleceu padrões de interface como menus suspensos, caixas de diálogo modais, e manipulação direta de objetos gráficos. Tecnicamente, o Mac OS original baseava-se em um núcleo de processamento cooperativo que, embora não oferecesse proteção robusta de memória ou multitarefa preemptiva, proporcionava uma experiência de usuário fluida e intuitiva. Sua arquitetura de recursos, no inglês: resource fork, permitia a incorporação de elementos gráficos, sonoros e de interface diretamente nos arquivos executáveis, facilitando a localização e personalização de aplicações.

-

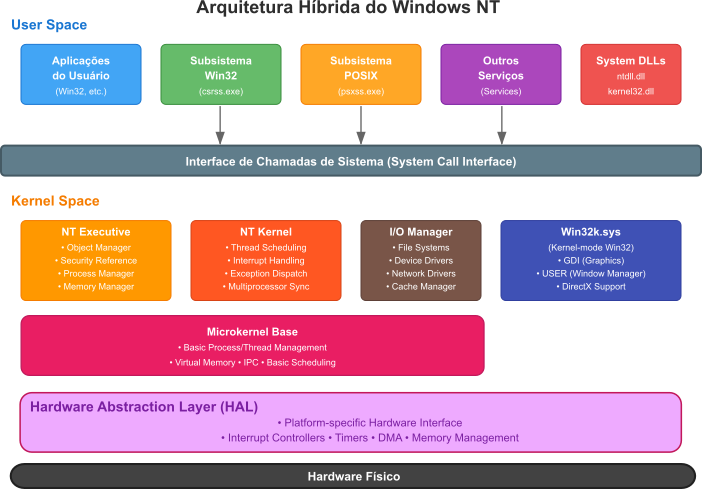

Microsoft Windows - Iniciado em 1985 como um ambiente gráfico executado sobre o MS-DOS, o Windows passou por três fases distintas de desenvolvimento. As versões 1.0 a 3.1 funcionavam essencialmente como ambientes gráficos, oferecendo uma interface visual para o MS-DOS subjacente, mas mantendo as limitações fundamentais de um sistema de 16 bits. O Windows 95 marcou um ponto de inflexão na evolução dos sistemas operacionais, introduzindo multitarefa preemptiva de 32 bits, um sistema de arquivos mais robusto, e uma interface redesenhada que incorporava elementos como a barra de tarefas e o menu Iniciar. Paralelamente, a linha Windows NT, iniciada em 1993 sob a liderança de Dave Cutler, representou uma abordagem completamente nova: um sistema operacional construído desde o foundation com arquitetura de 32 bits, microkernel híbrido, e recursos avançados de segurança baseados em Access Control Lists (ACLs) e domínios. O NT introduziu conceitos importados do padrão POSIX, como threading avançado, proteção de memória robusta, e suporte nativo a redes, estabelecendo as bases arquitetônicas que persistem nas versões modernas do Windows.

O Windows NT e o Padrão POSIX O Windows NT representou uma adaptação sofisticada de princípios estabelecidos da ciência da computação que já estavam padronizados ou implementados em sistemas UNIX. O POSIX.1 foi ratificado em 1988 precisamente quando Dave Cutler iniciou o desenvolvimento do NT na Microsoft, criando uma convergência histórica única. O POSIX.1b-1993, publicado apenas meses antes do lançamento do NT em julho de 1993, já havia padronizado extensões avançadas de tempo real incluindo escalonamento de prioridade, travamento de memória, objetos de memória compartilhada, filas de mensagens e temporizadores de alta resolução - capacidades que o subsistema POSIX mínimo do NT ignorou completamente.

Em 1993, os padrões POSIX definiam capacidades sofisticadas de multiprocessamento com escalonamento de prioridade de 32 níveis, arquivos mapeados em memória, semáforos e sinais de tempo real. O Windows NT implementou apenas a revisão básica POSIX.1-1990 para conformidade com contratos governamentais.

A o uso de threading é particularmente reveladora da influência do POSIX: enquanto o NT foi lançado com threading nativo em 1993, o Mach havia introduzido threads em sistemas semelhantes ao UNIX em 1985, oito anos antes. Os padrões de threading POSIX estavam em desenvolvimento durante a criação do NT e foram publicados como POSIX.1c em 1995.

O POSIX.1b-1993 especificou interfaces de travamento de memória, arquivos mapeados em memória, escalonamento preemptivo de prioridade fixa com mínimo de 32 níveis de prioridade, semáforos nomeados e não-nomeados, filas de mensagens e temporizadores de precisão de nanossegundos** - tudo antes do lançamento do NT.

A implementação POSIX real do NT foi deliberadamente mínima - suportando apenas chamadas de sistema básicas sem utilitários de shell, interfaces de threading ou extensões de tempo real. O subsistema POSIX da Microsoft era uma caixa de seleção para conformidade, não um esforço sério de compatibilidade UNIX.

As inovações genuínas do NT foram integração arquitetônica ao invés de avanços fundamentais. O design de microkernel híbrido suportando múltiplas personalidades de Sistema Operacional (Win32, POSIX, OS/2) simultaneamente foi arquitetonicamente inovador. A implementação abrangente da Camada de Abstração de Hardware excedeu as abordagens de portabilidade contemporâneas. A arquitetura de segurança integrada com controle de acesso baseado em capacidades representou um avanço genuíno sobre o modelo mais simples usuário/grupo/outros do UNIX.

A vantagem arquitetônica do NT residia em seu design unificado para multiprocessamento desde o início, enquanto os sistemas UNIX estavam gradualmente adaptando suporte SMP. O escalonador centrado em threads do NT e a preempção integrada do kernel representaram engenharia superior de conceitos estabelecidos ao invés de inovação.

No entanto, o UNIX mantinha vantagens significativas: os sockets BSD tiveram uma década de refinamento até 1993, fornecendo interfaces de programação de rede maduras e comprovadas. Os sistemas UNIX ofereciam ambientes de desenvolvimento sofisticados, estabilidade comprovada por meio de implantação em produção e serviços de rede abrangentes como NFS e frameworks de computação distribuída.

A comunidade técnica avaliou o NT como “VMS para hardware de PC” - uma caracterização precisa dado que Cutler transferiu diretamente conceitos de sua experiência com VMS. Alegações persistem de que o NT incorporou código do sistema operacional PRISM cancelado da DEC, apoiando ainda mais a narrativa de adaptação ao invés de inovação.

-

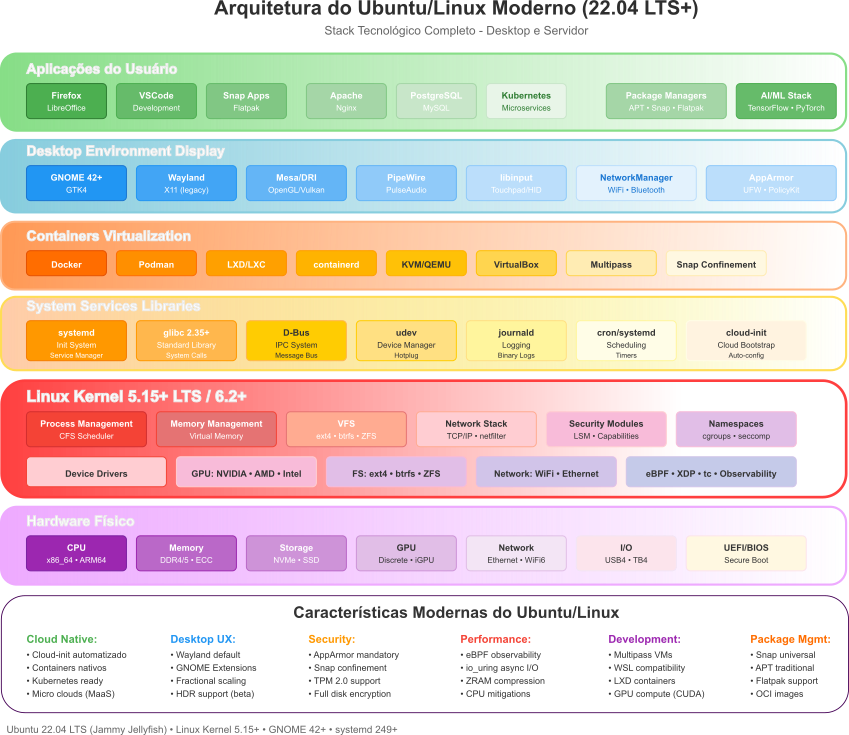

Linux - Concebido em 1991 por Linus Torvalds como um hobby pessoal para criar um sistema semelhante ao MINIX para computadores 386, o Linux evoluiu para se tornar um dos projetos de software livre mais bem-sucedidos da história. Sua arquitetura monolítica modular permite a incorporação dinâmica de funcionalidades por meio de módulos carregáveis, oferecendo flexibilidade sem comprometer performance. O desenvolvimento do Linux seguiu um modelo colaborativo distribuído sem precedentes, conhecido como “bazar” segundo Eric Raymond. Nesse modelo milhares de desenvolvedores contribuem simultaneamente para diferentes aspectos do sistema. Tecnicamente, o Linux implementa recursos avançados como gerenciamento de memória virtual, multiprocessamento simétrico (SMP), agendamento de tarefas em tempo real, e suporte extensivo a sistemas de arquivos diversos (ext4, Btrfs, ZFS). Sua natureza de código aberto, e a linguagem C, permitiram adaptações para uma variedade extraordinária de plataformas, desde supercomputadores até dispositivos embarcados, smartphones (Android), e sistemas de tempo real.

A Linux Foundation, criada em 2000, desempenhou um papel fundamental na promoção e suporte ao desenvolvimento do Linux, garantindo sua sustentabilidade e evolução contínua. O Linux não é apenas um sistema operacional; é uma plataforma que impulsiona a inovação em diversas áreas, desde servidores web até dispositivos móveis, e continua a ser um pilar fundamental da infraestrutura de TI moderna. Porém, do ponto de vista do desenvolvimento de sistemas operacionais dizemos que o Linux é o Kernel, ou núcleo, de um sistema operacional. Neste caso, um Kernel monolítico.

Figura 7: Lista dos Maiores Doadores da Linux Foundation.

Figura 7: Lista dos Maiores Doadores da Linux Foundation.

A era do PC inicialmente levou a uma simplificação de alguns recursos do Sistema Operacional em comparação com os Sistemas Operacionais de mainframe, mas gradualmente reintroduziu sofisticação conforme o hardware se tornava mais poderoso.

Fronteiras Modernas

As últimas décadas foram marcadas por uma proliferação sem precedentes de novas plataformas e paradigmas computacionais. Esta evolução transformou não apenas a forma como os seres humanos interagem com a tecnologia, mas também expandiu as capacidades de processamento, armazenamento e comunicação de dados. Desde os dispositivos móveis que se tornaram extensões de nossas vidas cotidianas, quase como órteses, até as vastas infraestruturas de computação em nuvem e os complexos sistemas distribuídos que sustentam a economia digital global, cada avanço representa um novo horizonte de possibilidades e tem impacto profundo nas tecnologias que usamos para desenvolver os sistemas operacionais.

Tecnologias como computação móvel, sistemas distribuídos, computação em nuvem e, mais recentemente, computação quântica e inteligência artificial estão moldando os sistemas operacionais modernos. Ao mesmo tempo em que só podem ser criadas graças a existência destes sistemas em uma laço de realimentação. Entre estas inovações, destacamos que a convergência entre Modelos de Linguagem de Grande Escala (LLMs) e computação quântica está força a criação urgente de uma nova geração de sistemas operacionais que combinará processamento de linguagem natural avançado com capacidades computacionais quânticas.

Sistemas Operacionais Embarcados e IoT: Conectando o Mundo Físico

Com o avanço da Internet das Coisas (IoT) e a proliferação de dispositivos conectados, os sistemas operacionais embarcados tornaram-se pilares fundamentais da infraestrutura tecnológica em 2025. Esses sistemas são projetados para operar em hardware com recursos limitados, como microcontroladores e sensores, garantindo eficiência, confiabilidade e, frequentemente, operação em tempo real. Diferentemente dos sistemas operacionais para desktops ou servidores, os sistemas embarcados priorizam baixo consumo de energia, tamanho reduzido de código e resposta determinística a eventos externos.

Características e Desafios dos Sistemas Operacionais Embarcados

Os sistemas operacionais embarcados, criados para ambientes restritos em recursos, como dispositivos portáteis, ou para ambientes de uso específico, como máquinas e robôs, ou ainda para aviônica e guerra, possuem características distintas dos sistemas operacionais genéricos tradicionais. Em 2025, as principais características incluem:

- Eficiência energética: algoritmos de gerenciamento de energia, como dynamic voltage and frequency scaling (DVFS), permitem que o sistema ajuste o consumo com base na carga de trabalho, essencial para dispositivos alimentados por bateria, como sensores IoT.

- Tamanho compacto: o código é otimizado para ocupar poucos kilobytes, adequando-se a microcontroladores com memória limitada (ex.: 32 KB de RAM).

- Tempo real: muitos sistemas embarcados são classificados como Real-Time Operating Systems (RTOS), garantindo respostas dentro de prazos estritos, como em dispositivos médicos ou controladores automotivos. Sistemas que analisaremos em uma seção posterior

- Conectividade: suporte a protocolos de rede leves, como MQTT e CoAP, permite comunicação eficiente em redes IoT, mesmo com largura de banda limitada.

- Segurança: Mecanismos como inicialização segura (secure boot), criptografia embarcada e atualizações over-the-air (OTA) protegem dispositivos contra ataques cibernéticos, um desafio crescente em dispositivos criados para integração com a internet e ubiquidade.

Os sistemas embarcados enfrentam desafios únicos característicos de ambientes com restrições de recursos e requisitos específicos de desempenho. Como não existem padrões universais de hardware nestes dispositivos os sistemas operacionais embarcados enfrentam um problema de fragmentação. Cada dispositivo pode ter diferentes microcontroladores, sensores e protocolos de comunicação, exigindo que os sistemas operacionais sejam altamente adaptáveis e modulares. Além disso, a segurança é uma preocupação crítica, pois a vulnerabilidade de um único dispositivo pode comprometer toda a rede IoT. A integração com inteligência artificial, especialmente com modelos leves como TinyML, está se tornando comum para permitir processamento local em dispositivos embarcados, aumentando a capacidade computacional necessária.

Além da fragmentação dos dispositivos, os sistemas embarcados que operam em dispositivos conectados à internet, IOT, enfrentam os problemas de Segurança em escala: Com bilhões de dispositivos IoT conectados, vulnerabilidades em um único dispositivo podem comprometer redes inteiras.

Recentemente, a Integração com sistemas de Inteligência Artificial, por meio da inclusão de modelos de Inteligência Artificial leves, uma demanda do mercado de dispositivos integrados a internet, levou a novos desafios. Maximize este problema considerando a existência de dispositivos militares, ou de aeronáutica, que exigem alta confiabilidade e segurança. A integração de modelos de IA em sistemas embarcados requer otimização cuidadosa para garantir que os dispositivos possam processar dados localmente sem comprometer o desempenho ou a segurança. Além disso, a necessidade de atualizações regulares de software para corrigir vulnerabilidades e melhorar funcionalidades é um desafio constante, especialmente em dispositivos implantados remotamente.

A curiosa leitora irá encontrar sistemas operacionais embarcados transformando setores como saúde (ex.: monitores cardiovasculares conectados), transporte (ex.: veículos autônomos), e indústria (ex.: robôs de montagem, manutenção e diagnóstico). Finalmente, a persistente leitora não deve deixar de notar que o design desses sistemas exige um equilíbrio delicado entre inovação tecnológica e responsabilidade social.

Exemplos de Sistemas Operacionais Embarcados

-

FreeRTOS: desenvolvido pela Amazon, o FreeRTOStext é um RTOS de código aberto amplamente utilizado em dispositivos IoT e embarcados. Sua arquitetura modular suporta microcontroladores de baixa potência, como os da família ARM Cortex-M. O FreeRTOS oferece escalonamento preemptivo, comunicação inter-tarefa via filas e semáforos, e integração com o AWS IoT Core para conectividade em nuvem. Em 2025, é comum em dispositivos como termostatos inteligentes e sensores industriais.

-

Zephyr: mantido pela Linux Foundation, o Zephyr um RTOS projetado para IoT, com suporte a uma ampla gama de arquiteturas (ARM, RISC-V, x86). Ele se destaca por sua escalabilidade, permitindo uso em dispositivos com apenas 8 KB de RAM, e por sua pilha de rede completa, incluindo Bluetooth Low Energy (BLE) e Thread. O Zephyr é usado em wearables, como smartwatches, e em redes de sensores para cidades inteligentes.

-

QNX: o QNX é um RTOS comercial baseado em microkernel, amplamente adotado em sistemas críticos, como automóveis e dispositivos médicos. Sua arquitetura modular e certificações de segurança (ex.: ISO 26262 para automotivos) o tornam ideal para aplicações onde falhas não são toleráveis. Em 2025, o QNX é usado em sistemas de assistência ao motorista (ADAS) e em dispositivos IoT industriais.

-

RIOT: o RIOT é um sistema operacional de código aberto voltado para dispositivos IoT de baixa potência. Ele suporta múltiplos protocolos de rede (ex.: 6LoWPAN, RPL) e é compatível com microcontroladores de 8 e 32 bits. Sua comunidade ativa e foco em interoperabilidade o tornam popular em projetos de pesquisa e protótipos de IoT, como redes de sensores ambientais.

Sistemas Operacionais Móveis

A ascensão dos dispositivos móveis, como smartphones e tablets, redefiniu a computação pessoal e impulsionou a necessidade de sistemas operacionais altamente especializados. Diferentemente dos sistemas para desktops, os sistemas operacionais móveis são projetados para operar em hardware com recursos inerentemente limitados em termos de capacidade de processamento, memória e autonomia de bateria.

Desde o iPhone (2005), o foco no design dos sistemas operacionais móveis centrou-se em interfaces de toque intuitivas, com a introdução de gestos multitoque como swiping e pinch-to-zoom, que se tornaram padrão e transformaram a experiência do usuário em um diferencial competitivo fundamental. Com impacto direto na criação de novos conceitos para o desenvolvimento dde sistemas operacionais, como a introdução de widgets e notificações interativas, que permitiram uma interação mais dinâmica e personalizada com o usuário. Além disso, a integração de sensores como acelerômetros, giroscópios e GPS ampliou as possibilidades de interação e personalização, permitindo que os dispositivos móveis se tornassem não apenas ferramentas de comunicação, mas também plataformas multifuncionais para uma variedade de aplicações, desde navegação até monitoramento de saúde.

As duas plataformas predominantes no mercado de sistemas operacionais móveis são o Android, desenvolvido pelo Google, e o iOS, da Apple. O Android é baseado no kernel Linux e adota um modelo de código aberto, o que permite aos fabricantes uma ampla customização e adaptação aos seus dispositivos, embora essa flexibilidade também contribua para a fragmentação do ecossistema. O Android utiliza o SQLite para armazenamento de dados estruturados e, historicamente, a máquina virtual Dalvik, posteriormente substituída pela Android Runtime - ART, para a execução de aplicativos desenvolvidos primariamente em Java ou Kotlin. O Android oferece suporte extensivo a uma vasta gama de tecnologias de conectividade, incluindo GSM/EDGE, CDMA, EV-DO, UMTS, LTE, 5G, Bluetooth, Wi-Fi e WiMAX.

O iOS é derivado do macOS e opera em um modelo de plataforma fechada, com uma integração vertical forte entre hardware e software, o que frequentemente resulta em alto desempenho e otimização de recursos. Sua arquitetura é organizada em camadas distintas: Core OS, que inclui o kernel do sistema operacional, gerenciamento de energia e segurança, Core Services, responsável por serviços como acesso a arquivos, rede e banco de dados SQLite, Media, para áudio, vídeo e gráficos, e *Cocoa Touch, que gerencia as interações do usuário, incluindo gestos multitoque e acesso a sensores.

A conectividade é uma das pedras angulares dos sistemas operacionais móveis, com suporte essencial para um amplo espectro de tecnologias de rede, incluindo Wi-Fi, redes celulares (3G, 4G e, cada vez mais, 5G) e Bluetooth, garantindo comunicação constante e acesso a serviços online. A chegada do 5G, com suas promessas de velocidades significativamente mais altas e latência ultrabaixa, impõe novas demandas aos sistemas operacionais móveis para gerenciar essas capacidades e habilitar novas classes de aplicações, como realidade aumentada (AR) e interações em tempo real mais ricas.

Segurança e privacidade são preocupações primordiais no design de sistemas operacionais móveis. Eles implementam modelos de permissão granulares, exigindo consentimento explícito do usuário para que aplicativos acessem recursos sensíveis como câmera, microfone, dados de localização e contatos. O sandboxing de aplicativos é uma técnica comum, isolando os processos e dados de cada aplicativo para prevenir interferências maliciosas e limitar o impacto de possíveis vulnerabilidades. A criptografia de dados, tanto em repouso no dispositivo quanto em trânsito pela rede, é amplamente utilizada para proteger informações sensíveis. Apesar desses mecanismos, os sistemas operacionais móveis enfrentam desafios contínuos devido à evolução constante de ameaças cibernéticas sofisticadas e à complexidade do ecossistema de aplicativos.

Sandboxing: Protegendo Sistemas Móveis

O sandboxing é uma técnica de segurança que isola aplicativos em ambientes restritos, mencionada nos sistemas operacionais móveis como Android e iOS. Cada aplicativo opera em um sandbox, com acesso limitado a recursos do sistema (como câmera ou contatos) e dados de outros aplicativos. Isso minimiza o impacto de vulnerabilidades, pois um aplicativo comprometido não pode afetar o sistema ou outros processos. Por exemplo, no iOS, o sandboxing é implementado via restrições do kernel, garantindo privacidade e estabilidade.

A amável leitora deve ter usado um destes sistemas operacionais móveis e percebido que ambos colocam uma ênfase significativa em segurança e privacidade, incorporando recursos como autenticação biométrica e criptografia de ponta a ponta para comunicações. No entanto, o gerenciamento eficiente de energia é, talvez, o desafio mais importante para os sistemas operacionais móveis, dada a dependência de baterias com capacidade finita. Para enfrentar essa questão, os sistemas operacionais móveis empregam estratégias sofisticadas. Estas estratégias incluem o gerenciamento dinâmico de estados de energia dos componentes de hardware, como a CPU, que pode operar em modos de baixo consumo ou ser colocada em estados de sleep durante períodos de inatividade. Isso só é possível graças a relação simbiótica entre o sistema operacional e o hardware, nesta relação, o sistema operacional é responsável por monitorar a atividade do usuário e ajustar dinamicamente o desempenho da CPU e outros componentes para otimizar o consumo de energia. Novamente em um laço de realimentação: há uma necessidade, cria-se um hardware que atenda a esta necessidade, o sistema operacional é adaptado para tirar proveito deste hardware, e assim por diante.

O Android, por exemplo, implementa seu próprio sistema de gerenciamento de energia sobre o Linux Power Management, utilizando wake locks para permitir que aplicações requisitem recursos da CPU apenas quando necessário, garantindo que a CPU não consuma energia desnecessariamente se não houver aplicações ou serviços ativos demandando processamento.

É possível que a observadora leitora tenha notado, nos últimos anos, a evolução das técnicas de gerenciamento de energia, transcendendo os modos manuais de economia para sistemas adaptativos e preditivos baseados em inteligência artificial. O Android introduziu recursos como Adaptive Battery, que aprende os padrões de uso do usuário para otimizar o consumo de energia, gerenciando o desempenho e a eficiência em segundo plano.Similarmente, o iOS, a partir da versão 19, deve introduzir otimizações de bateria baseadas em inteligência artificial, que aprendem os hábitos de uso de aplicativos, limitam atividades em segundo plano de forma inteligente e preveem necessidades de recarga, com todo o processamento ocorrendo no dispositivo para preservar a privacidade do usuário.

A atenta leitora deve ter em mente que esta transição para uma gestão energética proativa, na qual o Sistema Operacional antecipa e se adapta às necessidades do usuário de forma quase invisível, usando inteligência artificial, representa uma mudança fundamental, aliviando o usuário da carga cognitiva de gerenciar manualmente essas configurações. Tirando relação entre hardware e software do mundo determinístico da computação imperativa para o mundo probabilístico, mais fluido e adaptativo da inteligência artificial. Neste admirável mundo novo o sistema aprenderá e se ajustará continuamente às necessidades do usuário.

A crescente sofisticação da IA no gerenciamento de energia e na personalização da experiência do usuário, embora traga benefícios evidentes em termos de usabilidade e eficiência, também levanta questões importantes sobre a privacidade dos dados de uso do dispositivo. Mesmo com o processamento ocorrendo localmente no dispositivo, como destacado para o iOS, a coleta e análise detalhada de hábitos de uso – quais aplicativos são usados, em que horários, possivelmente inferindo locais e rotinas – são inerentemente sensíveis. Surge um dilema entre a conveniência da automação inteligente, que torna o gerenciamento de recursos “invisível e contínuo”, e a manutenção da transparência e do controle por parte do usuário sobre as operações do seu dispositivo. Enquanto algumas plataformas, como a One UI da Samsung, buscam oferecer “controles granulares”, a tendência geral da IA é para uma adaptação cada vez mais autônoma. Este equilíbrio delicado entre personalização avançada, privacidade e controle do usuário continuará a ser um campo de debate e desenvolvimento para os futuros sistemas operacionais móveis, podendo influenciar as preferências dos consumidores e até mesmo levar a novas regulamentações sobre os dados utilizados por IAs embarcadas.

A tabela a seguir apresenta um comparativo entre as duas principais plataformas de sistemas operacionais móveis, Android e iOS, destacando suas características fundamentais e abordagens recentes, especialmente no que tange ao gerenciamento de energia.

| Característica | Android | iOS |

|---|---|---|

| Arquitetura Base | Kernel Linux | Derivado do macOS, arquitetura em camadas (Core OS, Core Services, Media, Cocoa Touch) |

| Modelo de Distribuição | Código aberto, customizável por fabricantes | Plataforma fechada, proprietária da Apple |

| Interface Predominante | Interfaces de toque, alta customização da UI pelos fabricantes | Interfaces de toque (multitoque, gestos), design de UI consistente e controlado pela Apple |

| Gerenciamento de Energia | Android Power Management, wake locks, Adaptive Battery, controles granulares (One UI) | Gerenciamento de energia integrado, otimização de bateria baseada em IA (a partir do iOS 19) |

| Conectividade | Amplo suporte: GSM/EDGE, CDMA, EV-DO, UMTS, LTE, 5G, Bluetooth, Wi-Fi, WiMAX | Amplo suporte: GSM/EDGE, CDMA, EV-DO, UMTS, LTE, 5G, Bluetooth, Wi-Fi |

| Segurança | Sandboxing de apps, modelo de permissões, criptografia, Google Play Protect | Sandboxing de apps, modelo de permissões, criptografia forte, Face ID/Touch ID, Secure Enclave |

| Ecossistema de Aplicativos | Google Play Store, permite sideloading (instalação de apps de fora da loja oficial) | Apple App Store, política restrita de distribuição de apps |

Tabela 1: Comparativo entre Android e iOS, destacando suas características fundamentais e abordagens recentes, especialmente no que tange ao gerenciamento de energia.

A atenta leitora deve observar que esta comparação evidencia as filosofias distintas de design e as abordagens para desafios comuns, como o gerenciamento de energia, na qual ambas as plataformas estão convergindo para soluções mais inteligentes e adaptativas.

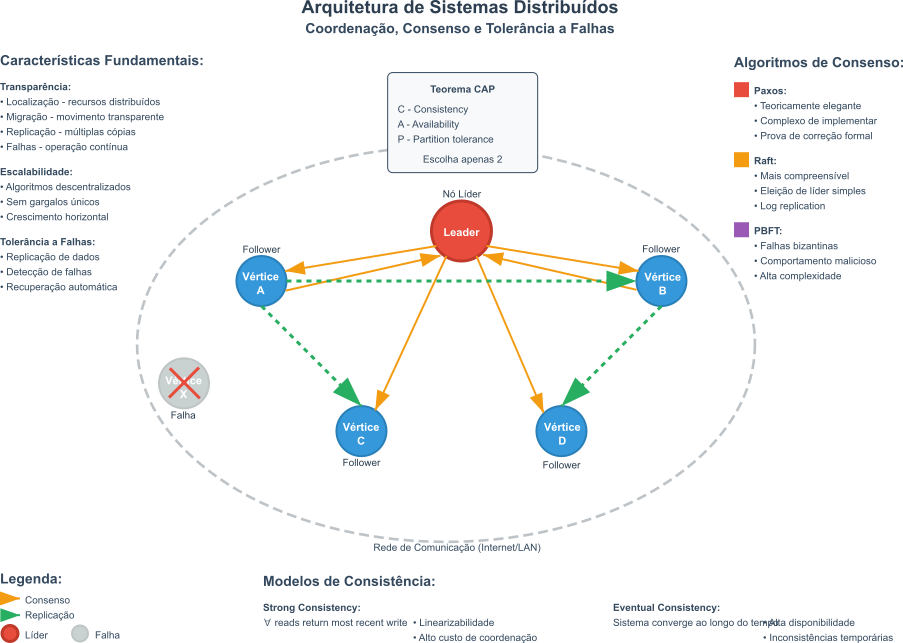

Sistemas Distribuídos

Um sistema distribuído é conceitualmente definido como uma coleção de computadores autônomos que se comunicam e cooperam por meio de uma rede, mas que se apresentam aos seus usuários como um único sistema coerente e unificado. Os principais objetivos para a construção de sistemas distribuídos são: o compartilhamento eficiente de recursos, hardware, software ou dados; o aumento de desempenho por meio do processamento paralelo; e a obtenção de maior confiabilidade e disponibilidade.

Para que um sistema distribuído funcione efetivamente e seja percebido como uma entidade única, ele deve exibir algumas características. Entre elas, destaca-se a transparência como uma das mais importantes. Neste caso, usamos a palavra transparência para fazer referência à capacidade do sistema de ocultar a separação e a distribuição de seus componentes dos usuários e dos programadores de aplicação. Existem diversas formas de transparência, sendo a transparência de localização e a transparência de acesso particularmente comuns.

A transparência de localização garante que usuários e aplicações não precisem conhecer a localização física dos recursos, enquanto a transparência de acesso assegura que recursos locais e remotos sejam acessados utilizando operações idênticas, abstraindo os detalhes de como o acesso é realizado. Mas, estas não são as únicas formas de transparência de Sistemas Operacionais Distribuídos. Outras formas incluem as transparências de replicação, falha, concorrência e migração, todas contribuindo para a ilusão de um sistema único.

A escalabilidade é outra característica importante. Neste caso, a escalabilidade denota a capacidade do sistema operar de forma eficaz e eficiente em diferentes escalas, ou seja, de se adaptar ao aumento da demanda por recursos sem que haja uma degradação significativa no desempenho ou a necessidade de alterar fundamentalmente o software ou as aplicações existentes. Em um mundo ideal, o processamento deve ser independente do tamanho da rede. No entanto, a escalabilidade pode ser limitada por gargalos como algoritmos centralizados, dados centralizados ou serviços centralizados que atendem a todos os usuários e que não possam ser distribuídos por limitações técnicas, econômicas ou de segurança.

Finalmente, a tolerância a falhas é a propriedade que permite a um sistema distribuído continuar operando corretamente, possivelmente com desempenho degradado, mesmo quando alguns de seus componentes falham. Isso é tipicamente alcançado por meio da redundância de hardware, software e dados, combinada com um design de software que permite a recuperação do estado consistente após a detecção de uma falha. As falhas podem ser classificadas como transientes, ocorrem uma vez e desaparecem, intermitentes, ocorrem esporadicamente, ou permanentes, persistem até serem reparadas. Intimamente relacionada à tolerância a falhas está a disponibilidade, que em sistemas distribuídos implica que a falha de um componente geralmente afeta apenas a parte do sistema que utiliza diretamente aquele componente, permitindo que o restante continue funcional.

Atualmente, uma das tendências mais significativas no desenvolvimento de sistemas distribuídos, com impacto direto na criação de sistemas operacionais, é a adoção da arquitetura de microserviços, que propõe a decomposição de aplicações monolíticas complexas em um conjunto de serviços menores, independentes e fracamente acoplados. Cada microserviço executa seu próprio processo e se comunica com outros serviços por meio de APIs (Interface de Programação de Aplicações) leves, frequentemente baseadas em HTTP/REST. Esta abordagem oferece benefícios como implantação independente de cada serviço, escalabilidade granular, permitindo que apenas os serviços mais demandados sejam escalados, e a possibilidade de usar diferentes tecnologias para diferentes serviços. A integração de microserviços com tecnologias de conteinerização, como Docker, e orquestradores, como Kubernetes, tem se mostrado particularmente eficaz para aumentar a tolerância a falhas e a resiliência, pois falhas em um microserviço podem ser isoladas sem derrubar toda a aplicação.

Outra tendência proeminente é a arquitetura orientada a eventos (Event-Driven Architecture - EDA). Em sistemas EDA, os componentes reagem a eventos, notificações assíncronas que representam ocorrências significativas, promovendo um baixo acoplamento entre eles e facilitando a escalabilidade. Por exemplo, em um sistema de comércio eletrônico, a conclusão de uma compra pode gerar um evento que é consumido por outros serviços, como o de faturamento, o de notificação ao cliente e o de expedição, sem que o serviço de compra precise conhecer diretamente esses outros serviços. O uso de servidores de mensagens, como Apache Kafka, é comum em EDAs para mediar a comunicação assíncrona.

O modelo distribuído AKKA, implementado por um toolkit e runtime para construir aplicações concorrentes, distribuídas e resilientes na JVM, Java Virtual Machine, baseado no modelo de atores, também ganhou tração para a construção de sistemas concorrentes e distribuídos resilientes e escaláveis. Os atores são entidades computacionais leves que se comunicam exclusivamente por meio da troca de mensagens assíncronas, embora padrões síncronos como “ask” possam ser implementados sobre a comunicação assíncrona “tell”. Estes atores podem ser distribuídos em um cluster de máquinas, permitindo que aplicações complexas sejam construídas a partir da composição de múltiplos atores colaborando para um objetivo comum. Aqui há uma relação interessante entre sistemas operacionais, sistemas distribuídos, máquinas virtuais e linguagens de programação. O AKKA é uma implementação do modelo de atores, que foi proposto por Carl Hewitt em 1973, e que foi inspirado no conceito de processos concorrentes do Lisp. O AKKA foi escrito em Scala, uma linguagem funcional que roda na JVM, e que permite a criação de aplicações distribuídas e reativas com alta performance e baixa latência.

A esperta leitora deve considerar que as novas tendências arquitetônicas, como microserviços e EDA, não surgem isoladamente, mas como respostas evolutivas diretas aos desafios de concretizar as características fundamentais de escalabilidade e tolerância a falhas em sistemas que se tornam progressivamente mais complexos e com demandas crescentes. Aplicações monolíticas tradicionais, por exemplo, enfrentam dificuldades intrínsecas para escalar componentes individuais de forma granular ou para isolar falhas eficazmente; uma falha em um módulo pode comprometer todo o sistema. Em contraste, a arquitetura de microserviços, ao decompor a aplicação em unidades menores e independentes, permite que cada serviço seja escalado conforme sua necessidade específica e que falhas sejam contidas dentro do serviço afetado, preservando a funcionalidade do restante do sistema. Similarmente, a EDA, ao promover o desacoplamento por meio da comunicação assíncrona baseada em eventos, aumenta a resiliência, os serviços não dependem diretamente da disponibilidade imediata uns dos outros< e a escalabilidade, os produtores de eventos podem operar independentemente dos consumidores.

A proliferação de componentes distribuídos, sejam eles microserviços, atores, ou os inúmeros dispositivos de borda em um sistema de IoT, acarreta um aumento exponencial na complexidade do gerenciamento do sistema como um todo. Manter a coerência, a eficiência, o monitoramento e a depuração em um ambiente com milhares ou milhões de partes móveis é um desafio formidável que deve ser enfrentado pelos Sistemas Operacionais. Isso aponta para uma possível evolução em direção a sistemas operacionais distribuídos, ou camadas de gerenciamento de sistema equivalentes, que incorporem níveis mais elevados de inteligência artificial e aprendizado de máquina. Tais sistemas poderiam realizar auto-configuração, auto-otimização, auto-reparação e gerenciamento proativo de recursos de forma mais autônoma, uma trajetória análoga à observada nos sistemas operacionais móveis com suas capacidades adaptativas de gerenciamento de energia.

A tabela a seguir resume as propriedades essenciais dos sistemas distribuídos e como as tendências arquitetônicas modernas se alinham e aprimoram essas propriedades.

| Paradigma/Característica | Descrição | Tecnologias/Exemplos Chave | Benefícios Principais |

|---|---|---|---|

| Transparência (Localização, Acesso) | Ocultar a distribuição dos componentes, permitindo acesso uniforme a recursos locais/remotos. | Middleware, RPC, Nomes de Serviço. | Simplificação do desenvolvimento, percepção de sistema único. |

| Escalabilidade | Capacidade de operar eficientemente em diferentes escalas, adaptando-se ao aumento da demanda. | Balanceamento de Carga, Replicação, Particionamento de Dados. | Suporte ao crescimento, desempenho consistente. |

| Tolerância a Falhas | Continuar operando corretamente mesmo com falhas em componentes, por meio de redundância e recuperação. | Replicação de Dados/Serviços, Checkpointing, Transações Distribuídas. | Alta disponibilidade, resiliência. |

| Arquitetura de Microserviços | Decomposição da aplicação em pequenos serviços independentes e fracamente acoplados. | Docker, Kubernetes, APIs REST/gRPC. | Implantação independente, escalabilidade granular, diversidade tecnológica, resiliência. |

| Arquitetura Orientada a Eventos (EDA) | Sistemas reagem a eventos assíncronos, promovendo baixo acoplamento e escalabilidade. | Apache Kafka, RabbitMQ, Filas de Mensagens. | Desacoplamento, escalabilidade, resiliência, capacidade de resposta em tempo real. |

| Computação de Borda/Névoa | Processamento de dados mais próximo da origem, reduzindo latência e uso de banda. | Dispositivos IoT, Gateways de Borda, Edge AI, Plataformas de Fog Computing. | Baixa latência, economia de banda, processamento em tempo real, privacidade aprimorada. |

Tabela 2: Propriedades essenciais dos sistemas distribuídos e como as tendências arquitetônicas modernas se alinham e aprimoram essas propriedades.

Esta visão panorâmica conecta os conceitos teóricos fundamentais dos sistemas distribuídos com as implementações práticas e as tendências que estão moldando ativamente este campo vital da computação.

Computação em Nuvem

A computação em nuvem teve, e tem, um impacto importante no projeto, desenvolvimento e suporte de sistemas operacionais. Este impacto pode ser analisado por meio de algumas das características deste sistema computacional.

O autoatendimento sob demanda, característico da nuvem, requer que sistemas operacionais suportem provisionamento automático de recursos por meio de APIs, eliminando a necessidade de configuração manual e exigindo mecanismos robustos de automação. Da mesma forma, o amplo acesso à rede, também muito importante na nuvem, demanda que sistemas operacionais sejam otimizados para plataformas e dispositivos diversos, necessitando de adaptabilidade e eficiência em ambientes heterogêneos de rede.

O agrupamento de recursos em modelos multilocatários impõe requisitos extras de isolamento e segurança aos sistemas operacionais. Os sistemas operacionais devem garantir que recursos físicos e virtuais sejam dinamicamente alocados entre múltiplos usuários sem comprometer a privacidade ou performance. Esta característica da nuvem exige mecanismos sofisticados de virtualização e controle de acesso.

A elasticidade, característica que permite os sistemas em nuvem de ajustar os recursos disponíveis de acordo com a demanda, representa o desafio mais significativo para sistemas operacionais. Sistemas operacionais devem ser capazes de ajustar dinamicamente recursos como CPU, memória e armazenamento em tempo real, respondendo a flutuações de demanda sem degradação de performance. Isso requer arquiteturas que suportem escalonamento horizontal e vertical automático, gerenciamento dinâmico de memória e otimização contínua de recursos.

O serviço mensurado, indispensável para a engenharia econômica dos sistemas em nuvem, exige que sistemas operacionais implementem capacidades extensivas de monitoramento e métricas, coletando dados detalhados sobre utilização de recursos para facilitar modelos de cobrança por uso e otimização de performance.

O provisionamento sob demanda, a criação de recursos computacionais, requer que sistemas operacionais suportem inicialização rápida, configuração automática e integração com interfaces de programação, permitindo que recursos sejam disponibilizados instantaneamente por meio de portais web ou APIs.

A multilocação, a arquitetura na qual uma solução de software atende múltiplos clientes, chamados de locatários, impõe requisitos fundamentais de segurança e isolamento aos sistemas operacionais. Estes devem garantir que múltiplos locatários compartilhem a mesma infraestrutura física mantendo completa separação de dados, processos e recursos, exigindo implementações robustas de virtualização e controle de acesso.

Além das características destacadas, os modelos de serviço populares na distribuição de computação em nuvem também influenciam o design de sistemas operacionais:

Software como Serviço (SaaS) requer sistemas operacionais otimizados para hospedar aplicações multi-usuário com alta disponibilidade e performance consistente. O sistema operacional deve ser transparente ao usuário final, focando na eficiência de execução de aplicações.

Plataforma como Serviço (PaaS) demanda sistemas operacionais que suportem múltiplas linguagens de programação, bibliotecas e frameworks, com capacidades de isolamento entre aplicações e gerenciamento automático de recursos de desenvolvimento.

Infraestrutura como Serviço (IaaS) requer sistemas operacionais que funcionem eficientemente como hosts de virtualização, suportando a criação e gerenciamento de múltiplas instâncias de sistemas operacionais convidados com performance próxima ao hardware nativo.

Esses requisitos transformam fundamentalmente como sistemas operacionais são projetados, exigindo arquiteturas mais modulares, eficientes em recursos, e capazes de operação autônoma em ambientes distribuídos e dinâmicos.

Inteligência Artificial e Modelos de Linguagem de Grande Escala (LLMs)

Os LLMs, como o GPT-4 ou modelos similares, são exemplos excelentes para avaliação dos impactos que as tecnologias de inteligência artificial terão sobre os sistemas operacionais. Os LLMs requerem recursos computacionais significativos, geralmente executados em sistemas de computação de alto desempenho equipados com GPUs, TPUs ou LPUs. Esses modelos possuem bilhões de parâmetros, exigindo processamento paralelo eficiente. Neste caso, a criativa leitora deve considerar que os sistemas operacionais deverão enfrentar os seguintes desafios:

- Alta Demanda Computacional: a execução de LLMs sobrecarrega a CPU, GPU e memória, exigindo sistemas operacionais que otimizem a alocação de recursos;

- Consumo de Energia: o treinamento e a inferência de LLMs consomem grandes quantidades de energia, com estimativas de até 1.287.000 kWh para treinamento, gerando preocupações ambientais com emissões de carbono de cerca de $552$ toneladas;

- Gestão de Memória: sistemas operacionais precisam gerenciar eficientemente grandes quantidades de memória para suportar os modelos, especialmente em dispositivos de borda com recursos limitados.

Existem também preocupações de segurança associadas ao uso de LLMs. Os LLMs podem ser explorados para gerar conteúdo malicioso, como e-mails de phishing ou código malicioso, representando riscos de segurança. Os sistemas operacionais precisam se adaptar para mitigar esses problemas atuando na Detecção de Conteúdo Malicioso, os sistemas operacionais podem e devem incorporar ferramentas de segurança avançadas para identificar e bloquear conteúdo gerado por LLMs que possa comprometer a segurança. Os sistemas operacionais também devem implementar medidas de Proteção de Dados, sistemas como os LLMs frequentemente requerem acesso a grandes quantidades de dados do usuário, os sistemas operacionais precisam implementar medidas robustas de proteção de dados para evitar vazamentos.

Integração de LLMs em Sistemas Operacionais